Ha destato scalpore la notizia che Geoffrey Hinton, detto il padrino dell’intelligenza artificiale, già premio Turing, abbia lasciato Google per poter parlare dei pericoli dell’IA. Non che gli fosse stato impedito di parlarne prima, ha precisato, ma ora sente la necessità di poterne parlare “senza dovermi preoccupare dell’impatto che le mie parole avranno su Google”.

Il suo timore è di essere stato un po’ come Oppenheimer. Il rischio che paventa è che stiamo costruendo un’arma che potrebbe spazzare via l’umanità, proprio come la bomba atomica. C’è da dire che non è il solo a sentire l’urgenza di sensibilizzare l’opinione pubblica sul tema. Già qualche settimana fa, un gruppo di scienziati e pensatori aveva proposto una moratoria di sei mesi allo sviluppo di intelligenze artificiali generative.

Queste paure sono recenti perché legate all’osservazione delle cosiddette “proprietà emergenti” dei modelli linguistici di grandi dimensioni ossia la capacità dei nuovi sistemi di intelligenza artificiale generativa di riuscire a svolgere attività che nessuno gli ha insegnato. In un recente speciale di CBS News si racconta di come un sistema di Google dopo un prompt in bengali sia stato in grado di rispondere in quella stessa lingua, anche senza un addestramento specifico.

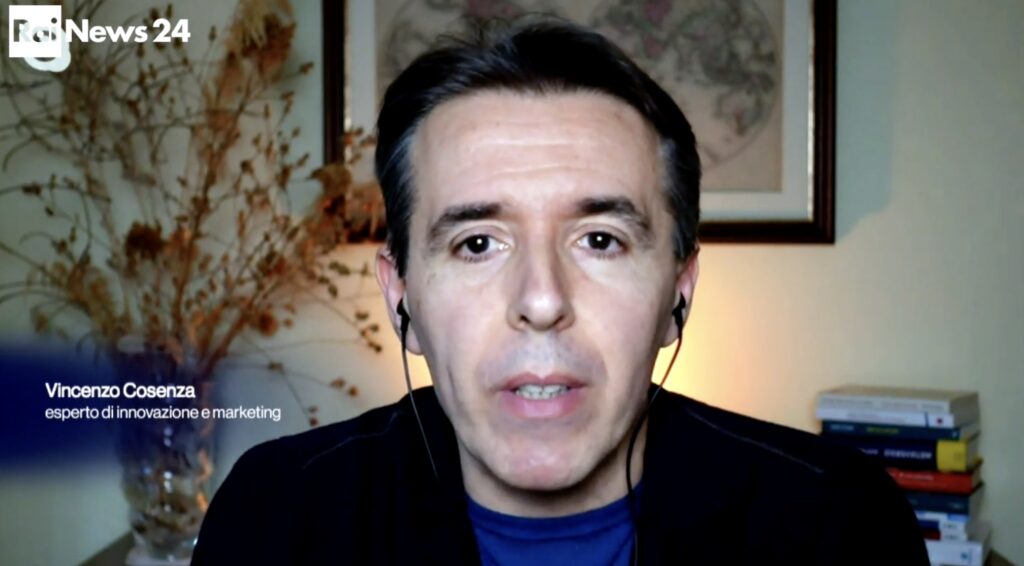

Di questi temi ho accennato in una intervista a Rainews del 2 maggio 2023.