Facebook ha pubblicato su Science uno studio teso a capire quale sia l’esposizione alle notizie e il comportamento degli utenti con chiare opinioni politiche.

L’analisi parte dall’individuazione di 7 milioni di notizie, dal luglio 2014 a giugno 2015, e si concentra su 226.00 articoli condivisi almeno 100 volte. I risultati sono molto interessanti, ma non vanno generalizzati perché riguardano solo un campione casuale di 10,1 milioni di statunitensi che hanno dichiarato di essere conservatori o liberali, pari al 9% della popolazione del social network.

Emerge che questi soggetti:

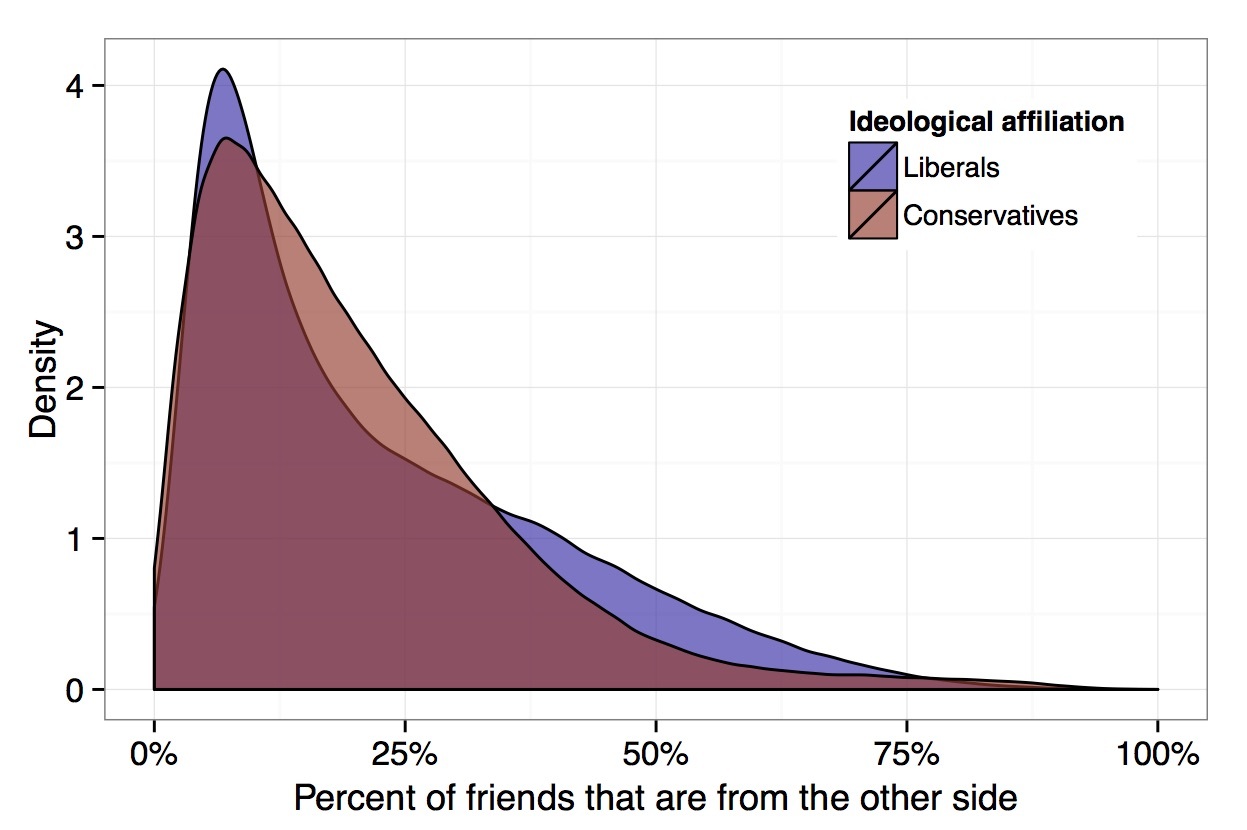

– hanno il 23% di amici di ideologia diversa dalla propria (come si vede dal grafico in basso i liberali tendono ad avere più amici conservatori)

– delle “hard news” (politica, economia,esteri) condivise dal proprio network mediamente il 29,5% è di stampo ideologico opposto al proprio

– tra quelle viste nel news feed lo è il 28,5%

– tra quelle cliccate il 24,9% ha un contenuto non in linea con le proprie idee. Viene anche rilevato che sulla quantità di click incide il posizionamento della notizia nel news feed, decisa dall’algoritmo sulla base dell’apprezzamento espresso dagli amici. Più è in alto la notizia, più ci sono probabilità che venga cliccata.

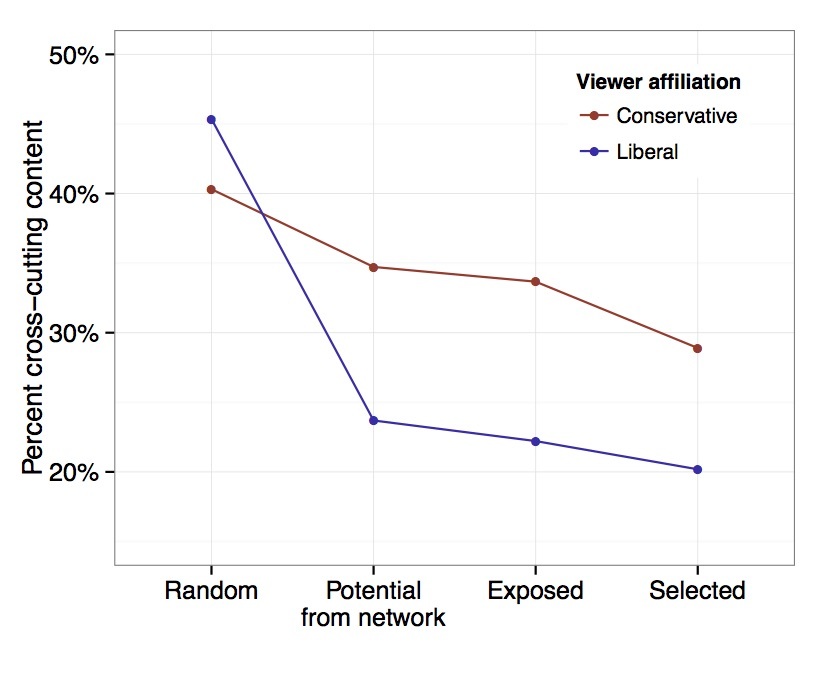

L’effetto delle notizie “non allineate” con la propria ideologia sui due gruppi è riassunto nel grafico in basso.

Se i gruppi fossero esposti ad un campione casuale (random) di tutte le notizie, i liberali vedrebbero circa il 45% di notizie gradite ai conservatori, viceversa questi ultimi ne vedrebbero il 40%.

In realtà accade che il 23% delle notizie condivise dagli amici (potential from network) dei liberali è di natura ideologica opposta, mentre quello che effettivamente viene visto (esposed) è il 22%. Ciò vuol dire che c’è un 8% in meno di probabilità di vedere contenuti “diversi” condivisi dai propri amici, a causa dell’algoritmo di Facebook (risk ratio).

Al contrario il 34% dei contenuti condivisi dai conservatori è di natura ideologica opposta, ma solo il 33% viene effettivamente visto. Qui il “risk ratio” è del 5%.

Inoltre i conservatori risultano meno propensi dei liberali a cliccare (selected) su contenuti non in linea con le proprie opinioni.

Secondo i ricercatori questi risultati mostrerebbero che le persone vengono esposte ad un sostanziale numero di notizie lontane dalle proprie convinzioni. Quindi l’effetto della cosiddetta “echo chamber” sarebbe ridotto. Vero, ma comunque questo effetto esiste e viene dimostrato scientificamente per la prima volta da Facebook.

Quanto sia dovuto all’algoritmo e quanto alle scelte fatte da ognuno di noi, in primis nella selezione degli amici, rimane questione difficile da districare.

Ma per i ricercatori non ci sono dubbi: la composizione del network gioca un ruolo fondamentale, mentre l’azione dell’algoritmo avrebbe un impatto modesto. Ciò è vero nelle condizioni riprodotte dallo studio, ma se l’osservazione fosse estesa all’intera popolazione? Probabilmente l’effetto “filter bubble” risulterebbe più ampio, anche in considerazione del lavoro degli algoritmi sulla visibilità dei contenuti sponsorizzati.