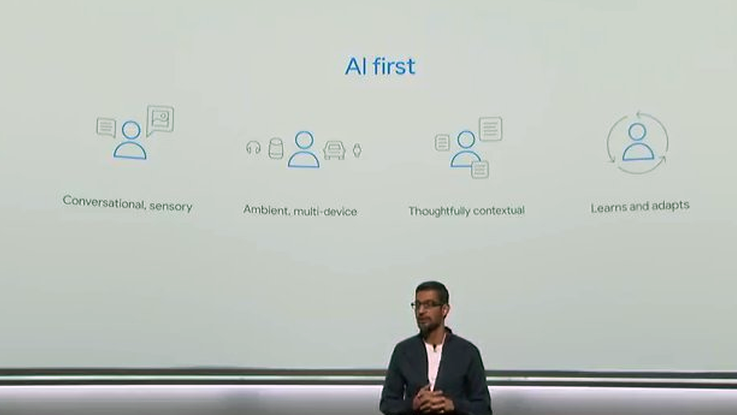

Lo scorso anno Sundar Pichai, CEO di Google, aveva delineato il nuovo corso dell’azienda: da “Mobile First” ad “AI first“. Ieri ha rimarcato il concetto presentando una serie completa di prodotti consumer, frutto della sinergia di hardware, software e Intelligenza Artificiale (IA).

La cosa interessante è che, a differenza degli altri player, che vedono l’Intelligenza Artificiale come una feature da aggiungere ai loro prodotti, l’azienda di Mountain View prova a progettare manufatti ispirati dai progressi nel campo dell’Intelligenza Artificiale e plasmati attorno ad essi. Pichai afferma che la prima domanda che si pone è “Come possiamo applicare l’IA per ripensare il prodotto”?

La strategia potrebbe risultare vincente in un mondo in cui l’hardware dei prodotti consumer va appiattendosi su componentistica simile, quando non identica. Inoltre proprio sul software “intelligente” Google ha investito prima degli altri e oggi può vantare su un notevole vantaggio competitivo. Un recente report di Business Insider ha calcolato che i sistemi di Intelligenza Artificiale di Google hanno un quoziente intellettivo di 47,3, più alto di Baidu (33), Bing (32) e Siri (24).

La visione di Pichai è quella di arrivare ad un mondo “AI first” in cui:

– le persone saranno in grado di interagire con le tecnologie (computing) in modo naturale e senza soluzione di continuità

– l’intelligenza computazionale sarà ambientale, perché incorporata in diversi oggetti quotidiani

– gli oggetti intelligenti saranno in grado di comprendere il contesto per fornire le risposte giuste, anche anticipando i bisogni

– il software incorporato negli oggetti imparerà dalle abitudini e si adatterà costantemente.

I prodotti presentati ieri hanno tutti un cuore di Intelligenza Artificale sia perchè tutti incorporano Google Assistant (l’assistente virtuale che nasce come personificazione del motore di ricerca), sia perché grazie a miglioramenti algoritmici permettono di aumentare il valore degli oggetti. Vediamone alcuni esempi:

Google Pixel 2

Il nuovo smarphone progettato interamente da Big G. pur non presentando aspetti rivoluzionari, mostra dei miglioramenti interessanti nel campo dell’IA applicata alla fotografia e al riconoscimento delle immagini.

Il Pixel 2 ha la migliore resa fotografica del mercato come dimostrato dai benchmark di DXoMark che le assegnano un punteggio di 98 rispetto ai 94 di iPhone 8 Plus e Samsung Galaxy Note 8.

Pur avendo una sola fotocamera posteriore riesce a superare quello che iPhone fa con due fotocamere, proprio grazie ad innovazioni software. E’ il caso dell’effetto bokeh (lo sfondo sfocato per dar risalto ai ritratti) che diviene possibile grazie ad una mappatura dell’immagine. Ogni pixel mappato contiene due informazioni: una vista da destra e una da sinistra. La differenza di prospettiva tra i due pixel viene elaborata da algoritmi di machine learning opportunamente addestrati, che arrivano a restituire un’immagine in grado di simulare la profondità.

Google Lens

Si tratta di un software, per ora disponibile solo su Pixel 2, che “dona la vista” allo smartphone e permette una ricerca visuale. Ad esempio puntando la fotocamera su oggetti reali, sarà possibile vedere in sovrapposizione una serie di informazioni aggiuntive: per un libro o un negozio le recensioni, per un monumento la descrizione, e così via. Lens è l’espressione dei progressi nel campo della visual recognition, in cui gli algoritmi vengono addestrati per riconoscere le immagini.

Google Pixel Buds

Gli auricolari wireless di Google sono caratterizzati dalla presenza di Google Assistant e, accoppiati ad un dispositivo Android, permettono una funzione impressionante: la traduzione simultanea delle frasi pronunciate. Nella demo presentata l’utente pronunciava una frase in inglese e l’assistente ne riproduceva l’audio in svedese e viceversa, in modo da permette il dialogo tra persone di lingua diversa.

Google Clips

Si tratta di una piccola fotocamera quadrata che, una volta attivata, è in grado di catturare automaticamente sette secondi di foto in sequenza, scegliendo i momenti più interessanti. Qui l’Intelligenza Artificiale opera per riconoscere volti e azioni viste dall’occhio della fotocamera, per poi proporre quelle che potrebbero essere più memorabili, evitando ore di montaggio. L’elaborazione avviene completamente in locale, senza l’invio di informazioni ai server di Google.

Google Home Max

E’ la nuova cassa acustica con Google Assistant che, come Apple HomePod, adatta il suono riprodotto al contenuto (la musica ad un volume più alto rispetto ad un podcast), all’ambiente in cui si trova e al rumore circostante. In questo caso l’Intelligenza Artificiale opera nel riconoscimento degli ambienti e nel miglioramento del suono.

Siamo ancora nella fase embrionale dell’Intelligenza Artificiale, ma questi esempi dimostrano che si aprono prospettive finora inesplorate in grado di migliorare le nostre esperienze e il nostro modo di percepire la realtà circostante.

Comments are closed.