Negli ultimi anni il cellulare ha subìto diverse trasformazioni. In una prima fase, quando la funzione d’uso prevalente era quella della comunicazione vocale, i produttori hanno puntato alla portabilità grazie alle tecnologie di miniaturizzazione. Poi, con la massificazione del web e delle app, la funzione d’uso si è spostata verso la navigazione e i giochi, e ciò ha richiesto schermi più brillanti, dimensioni maggiori.

Tale evoluzione è stata assecondata dai progressi nel campo dei microprocessori: sempre più compatti, potenti e specializzati (attualmente in uno smartphone accanto alla CPU, si trova anche una GPU, cui sono demandati i calcoli grafici).

Oggi la parte più importante di uno smartphone sta diventando la fotocamera (o meglio le fotocamere) tanto che sarebbe più corretto parlare di smartcamera o di “computer dotato della vista”.

I lanci dell’iPhone X e del Pixel 2 hanno reso lampante questa affermazione. I nuovi feticci di Apple e Google sono un concentrato di tecnologie, le più avanzate delle quali servono a migliorare la fotocamera, che diventa l’elemento centrale del device. Non più solo componente che serve a riprodurre fedelmente la realtà, ma anche a migliorare la sicurezza e ad abilitare le funzioni di realtà aumentata.

Fotocamera come dispositivo di sicurezza

Nell’iPhone X la fotocamera diventa dispositivo di sicurezza in quanto necessaria per riconoscere il possessore del telefono e sbloccarlo, al fine di abilitarne le funzioni, tra cui quella di esecuzione dei pagamenti.

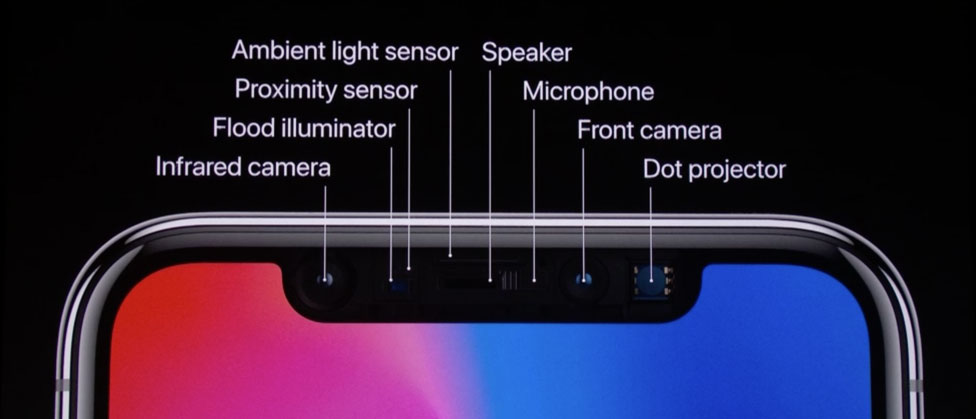

Tutto ciò, che Apple chiama Face ID, è possibile grazie ad un sistema, denominato TrueDepth Camera System, composto da un proiettore di punti, da una fotocamera infrarossi e da un illuminatore, coordinati dal processore A11 Bionic.

In pratica il soggetto, anche se al buio, viene illuminato da un fascio che proietta 30.000 punti sul viso, in modo da creare un modello matematico dello stesso. Questa mappa-impronta tridimensionale viene criptata e conservata nel “Secure Enclave”. Quando l’utente fissa il device, da qualunque posizione, il chip A11 Bionic (in grado di eseguire fino a 600 miliardi di operazioni al secondo) confronta la mappa con l’immagine restituita dalla fotocamera per verificarne la corrispondenza. Giorno dopo giorno gli algoritmi di machine learning elaborati dal chip sono anche in grado di registrare i cambiamenti nel volto e aggiornare il modello.

Il sistema risulterebbe più sicuro di quello implementato da Samsung sul Galaxy S8, con la possibilità di un solo errore su 1.000.000 di tentativi.

Fotocamera come abilitatrice della Realtà Aumentata

La fotocamera è anche un elemento abilitante per fruire delle applicazioni di realtà aumentata, ossia quelle che permettono di visualizzare elementi digitali sovrapposti allo spazio fisico inquadrato.

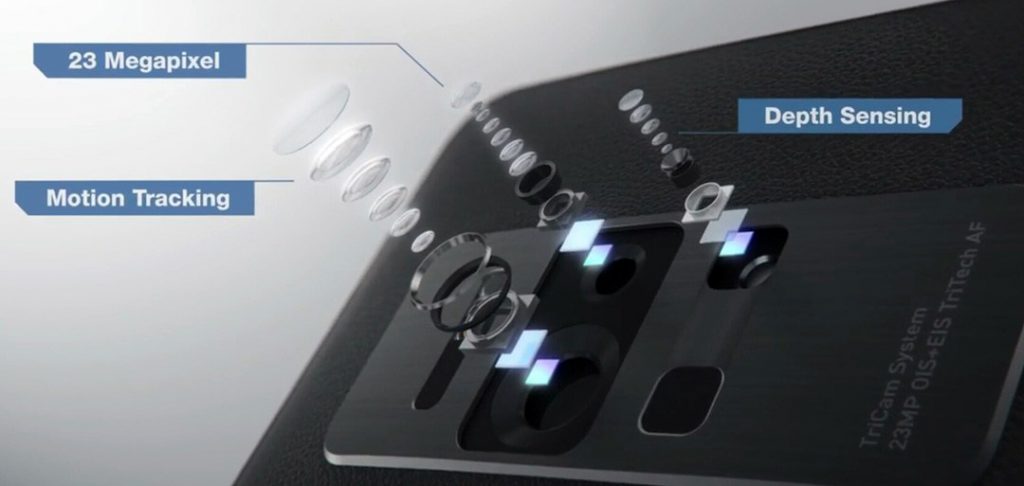

Far funzionare la realtà aumentata su dispositivi mobili non è cosa semplice. Richiede diverse tecnologie hardware e software, fino a poco tempo fa non disponibili. Una fotocamera avanzata, in grado di percepire la profondità e riprodurre fedelmente l’ambiente circostante, una fotocamera per tracciare il movimento dell’utente, una fotocamera a infrarossi per calcolare la distanza dagli oggetti inquadrati, un GPS, una bussola, un accellerometro e sensori ambientali. Infine un software in grado di orchestrare le funzioni hardware e permettere agli sviluppatori la creazione di applicazioni di realtà aumentata (quello di Apple si chiama ARKit, quello di Google ARCore).

Questi elementi, inizialmente disponibili solo su alcuni smartphone come lo Zenfone AR, poi su Google Pixel e S8 e iPhone X, diventeranno l’equipaggiamento di base dei prossimi dispositivi mobili e trasformeranno il nostro modo di interagire col mondo circostante.

Le applicazioni sono tutte da realizzare, ma riguarderanno certamente i giochi (sempre più realistici e coinvolgenti) e l’arricchimento degli oggetti reali con uno strato informativo (vedi Google Lens).

Fotocamera per migliorare la fotografia

Ovviamente l’evoluzione delle componenti fisiche delle fotocamere (due frontali, grandangolo e tele, più una posteriore) unita ai progressi software (soprattutto l’applicazione di algoritmi di machine learning) e alle capacità di elaborazione di CPU e GPU, stanno avendo un impatto senza precedenti sulla creazione di foto e video.

A tal proposito si parla di “fotografia computazionale”. I primi esempi sono stati la tecnologia HDR+ sui Google Pixel per (ri)produrre paesaggi correttamente esposti e la funzione Portrait Mode sull’iPhone 7 Plus, che faceva uso della doppia fotocamera (una per isolare il viso e l’altra per lo sfondo) e di algoritmi di machine learning per far risaltare i ritratti, sfocando lo sfondo nel tentativo di riprodurre l’effetto “bokeh” delle ottiche più costose.

Nel nuovo Pixel 2 questo effetto è ottenuto con una sola fotocamera e demandando agli algoritmi la mappatura della profondità. La tecnica è nota come Phase-Detect Auto-Focus (PDAF) o Dual-Pixel AutoFocus (DPAF). In pratica la lente della fotocamera posteriore registra la luce da sinistra e da destra e quindi ogni pixel è formato da due pixel. I due punti di vista differiscono solo di 1mm, ma ciò basta per produrre una mappa di profondità e dunque permettere agli algoritmi (convolutional neural network) di distinguere l’oggetto in primo piano dallo sfondo, da sfocare.

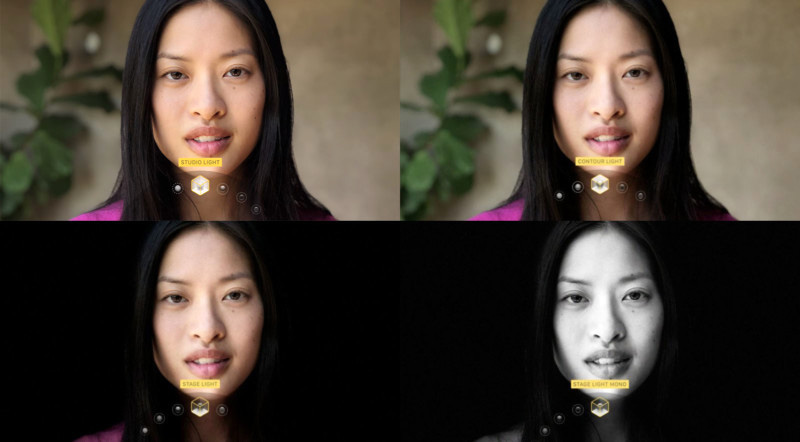

Le tecniche di machine learning sono anche usate per permettere l’applicazione di illuminazioni diverse ad uno stesso scatto (“Portrait Lightining” su iPhone 8 Plus e iPhone X). Per raggiungere un effetto naturale gli algoritmi sono stati istruiti per apprendere e riprodurre, in tempo reale, l’illuminazione usata da pittori e fotografi illustri, dopo aver realizzato una mappa del viso inquadrato.

Non mi addentro nelle implicazioni filosofiche che la massificazione della fotografia computazionale comporta, ma ricordo solo che la tecnologia ha sempre influito sulla storia della fotografia nel tentativo di liberarla da sovrastrutture (regole e tecnicismi).

In definitiva lo smartphone, da oggetto per la comunicazione e protesi del nostro orecchio, sta cambiando e continuerà a cambiare per diventare soprattutto protesi del nostro occhio, sempre più centro della nostra conoscenza aumentata.