A 8 anni di distanza dal suo ultimo prodotto e dopo 10 anni di sviluppo Apple ha presentato Vision Pro, un visore per le realtà estese, in particolare per la “mixed reality” cioè per riprodurre digitalmente la realtà circostante, aggiungendovi nuovi elementi digitali. Questo vuol dire che il dispositivo offre diversi gradi di immersività, da bassa ad alta a seconda della decisione dell’utente.

Le reazioni di chi l’ha provato sono molto positive, ma non sono mancate le critiche da parte di chi lavora da anni nel settore.

Diciamo innanzitutto che abbiamo a che fare con un prodotto di fascia alta che costerà 3.499 dollari. In realtà, forse dovremmo parlare di MVP (minimum viable product) perché arriverà sul mercato solo tra un anno e inizialmente solo negli Stati Uniti.

Gli aspetti positivi

Sulla base delle recensioni che ho letto in giro possiamo dire che gli aspetti più apprezzati sono 3: la qualità costruttiva del visore, la qualità della visione (per molti è il miglior passthrough esistente) e la sua semplicità di utilizzo.

I primi due afferiscono soprattutto alle caratteristiche hardware del visore che confermano l’eccellenza di Apple in questo campo.

Il visore è in alluminio con la parte frontale in vetro laminato curvo. Dentro ci sono 12 videocamere (2 sono TrueDepth, 2 sono a infrarossi), 5 sensori (tra cui uno scanner Lidar), 6 microfoni, 2 display da 4K per occhio (23 milioni di pixel grandi 7,5 micron ciascuno). Ma restano oscuri tanti dettagli tecnici che sarebbero utili per fare un paragone con prodotto simili sul mercato (Varjo) come l’ampiezza del campo visivo, del refresh rate e della gamma di regolazione della distanza interpupillare (IPD).

Nelle stanghette laterali sono nascosti due speaker incaricati di generare l’audio spaziale, adattandolo alle dimensioni e agli oggetti presenti nella stanza (dopo averli scansionati con una tecnologia di “audio raytracing”).

Il sistema utilizza due processori Apple: un M2 e un nuovo chip chiamato R1 che ha il compito di processare velocemente le immagini reali e riprodurle sugli schemi che abbiamo di fronte.

Questa potenza computazionale non “renderizza” solo l’ambiente esterno, ma anche il volto e gli occhi dell’utente che vengono resi visibili, con un effetto trasparenza, a chi non indossa il visore e si trova ad entrare nella stanza (funzione chiamata “EyeSight”).

L’altro aspetto positivo è la semplicità di utilizzo che si deve al nuovo sistema operativo visionOS e al nuovo metodo di interazioni uomo-macchina. In pratica l’utente non ha bisogno di controller, ma può utilizzare occhi, mani e voce per interagire con le applicazioni.

In particolare sembra essere fenomenale la possibilità di spostare il focus da un’app ad un’altra semplicemente spostando gli occhi. Poi per attivare l’app basta unire pollice e indice. Le mani servono anche a spostare le finestre e a ridimensionarle. Inoltre la voce può essere utile quando abbiamo bisogno di dettare alcune informazioni (ma mi sarei aspettato un ruolo di Siri più prominente).

Cosa non mi convince

L’aspetto negativo rilevato da quasi tutti è la presenza di una batteria esterna che deve essere collegata al visore. Scelta, ovviamente, dettata dalla volontà di alleggerire il carico del visore. Altro problema è che l’autonomia massima dichiarata è di 2 ore. Poche, anche solo per vedere un film.

Il problema più grande che vedo è l’assenza di casi d’uso convincenti tra quelli fatti vedere da Apple. Molto spazio è stato dato all’utilizzo per motivi di svago: la visualizzazione di foto in alta qualità giganti e panoramiche, di film simulando l’effetto della sala cinematografica, di giochi (usando un controller). Ma la sensazione è quella di mera sostituzione degli schermi attuali con schermi più vicini ai nostri occhi. Abbiamo visto gli utilizzatori sempre su un divano o in piedi, ma mai in movimento dentro ambienti tridimensionali.

Anche nei casi lavorativi presentati non si va oltre l’effetto Minority Report, seppure molto “cool”. Abbiamo visto la possibilità di spostare foto da iMessage a Keynote con l’uso delle mani, di fare una video conferenza con dei simulacri a mezzo busto e di collaborare con colleghi interagendo con oggetti tridimensionali.

Tutti use case già visti in altre presentazioni, ma comunque poco per giustificare l’acquisto e l’utilizzo di un prodotto, soprattutto a quel prezzo. Certo, potrebbe essere solo questione di tempo perché ora sta agli sviluppatori capire come sfruttare questo nuovo ambiente di sviluppo che è visionOS. Ma il fatto che Apple non abbia presentato casi strabilianti è emblematico (l’unico effetto wow l’ho avuto quando ho visto la possibilità di usare il visore come una videocamera per l’acquisizione di video con un effetto di profondità).

Strategia di posizionamento e comunicazione

Quella che abbiamo visto al WWDC è stata una grandiosa operazione di marketing per parlare agli sviluppatori e ai consumatori, tutta fatta di video ben costruiti e senza demo live (tra l’altro nessun manager si è fatto vedere con indosso i Vision Pro).

Agli sviluppatori il messaggio è stato: questo è il momento di creare applicazioni sfruttando le tre dimensioni e dunque visionOS con i suoi strumenti di sviluppo.

Ai consumatori, anche a quelli che non potranno permettersi di acquistare il visore, Apple ha comunicato una rinnovata capacità di creare prodotti innovativi (ricordiamoci che la maggior parte delle persone non conosce qual è lo stato dell’arte). E lo ha fatto usando un linguaggio semplice e diverso da quello degli altri player. Non ha usato mai termini come metaverso, realtà virtuale, avatar (li chiamano “personas”) o mondi virtuali.

Vision Pro è stato definito come una nuova piattaforma di “spatial computing” (sarà interessante vedere come verrà chiamata in Italia). Il computer del futuro, indossabile, la cui potenza computazionale produce contenuti con i quali interagire naturalmente, intorno a noi, nello spazio.

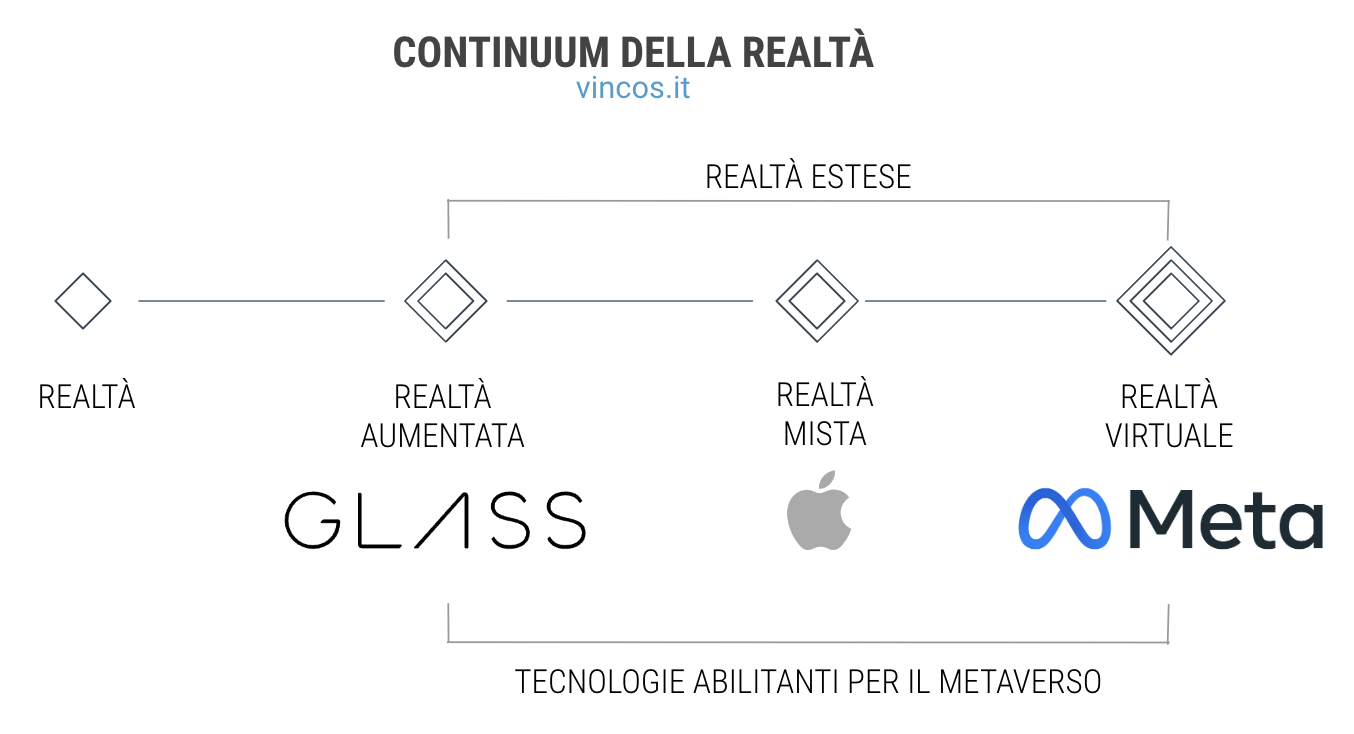

È ovvio che questo posizionamento serve a differenziarsi dai concorrenti, ma anche a rendere più accettabile la strada verso il metaverso, inteso come internet del futuro ossia l’insieme delle esperienze connesse immersive che nei prossimi anni diventeranno sempre più comuni.

Se questo sarà l’approdo finale, e io ho pochi dubbi in merito dato che lo sostengo dalla scrittura di “Marketing Aumentato”, la strategia di Apple è diametralmente opposta da quella di Meta e di altri player.

Apple parte dalla realtà mista per non spaventare gli utenti. Non a caso il messaggio nel video di presentazione sottolinea “quando indossi Apple Vision Pro vedi il tuo mondo con l’aggiunta delle tue app preferite”. Meta è partita dalla realtà virtuale (e dai giochi che rappresentano il motivo principale di acquisto) per poi allargare il campo alla realtà mista (sia il Quest Pro che il prossimo Quest 3 hanno un passthrough anche se forse non ai livelli di Vision Pro, che però costa molto di più).

Insomma, la bomba lanciata da Apple non credo sarà la fine delle ambizioni di Zuckerberg. Anzi farà bene al mercato e accelererà la trasformazione delle nostre esperienze. Stimolerà la competizione verso la realizzazione di device più comodi e potenti, ma anche di applicazioni più utili e coinvolgenti. C’è da sperare, soltanto, che gli ecosistemi stimolati dai grandi player diventeranno più aperti che chiusi e che le nostre esperienze saranno più sociali e meno solitarie di quelle viste nelle demo di Apple.