Una delle domande che mi sento fare più spesso è se gli strumenti di intelligenza artificiale generativa hanno un impatto concreto sulla produttività individuale dei lavoratori di concetto (knowledge workers). Una risposta scientifica a questo quesito la dà un paper scritto da alcuni professori della Harvard Business School e Boston Consulting Group, dal titolo “Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality“.

I ricercatori hanno esaminato l’impatto dei nuovi chatbot su 18 attività “knowledge-intensive“, svolte dai consulenti di BCG. Gli esperimenti hanno coinvolto 758 persone e sono stati condotti dopo aver individuato un livello base (baseline) nelle performance per svolgere i task progettati. Poi, casualmente, i partecipanti sono stati divisi in gruppi: senza accesso all’IA, con accesso a GPT-4, con accesso a GPT-4 e con nozioni di prompt engineering.

Il risultato principale è stato che, in tutti i task, coloro che hanno usato l’IA di OpenAI hanno ottenuto risultati migliori rispetto a coloro che non l’hanno usata, in ogni dimensione misurata (qualità dell’output, tempo di lavoro, numero di task portati a termine).

In particolare, i consulenti che hanno usato GPT-4 hanno completato il 12,2% di attività in più, hanno completato le attività il 25,11% più rapidamente e prodotto risultati di qualità superiore del 40% rispetto agli altri. Una cosa interessante è che la valutazione della qualità è stata fatta fare ad umani e a diverse intelligenze artificiali che hanno concordato tra loro sul risultato.

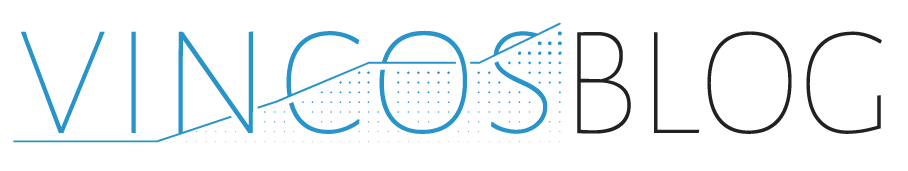

Nel grafico in basso si può notare come, mediamente, migliora la qualità dell’output passando dal gruppo di coloro che non avevano a disposizione l’IA al gruppo di quelli che invece l’hanno potuta usare. Nel dettaglio, si noti come i rossi mostrano i risultati migliori perché sono coloro che hanno anche ricevuto un addestramento aggiuntivo su come usare al meglio il sistema (qui emerge l’importanza di un training specifico sul prompt design).

La frontiera frastagliata dell’IA generativa

Gli esperimenti sono stati condotti facendo svolgere ai partecipanti attività realistiche di consulenza per conto di un cliente fittizio (un’azienda di produzione di scarpe). Ad esempio, attività creative (come proporre 10 idee per un nuovo mercato o sport), analitiche (come segmentare il settore delle scarpe in base agli utenti), di marketing (come scrivere un comunicato stampa per il lancio di un prodotto) e ispirazionali (scrivere un memo ispirazionale rivolto ai dipendenti per spiegare perché il nostro prodotto è migliore di quello degli altri).

Sembravano tutti compiti alla portata di un modello linguistico come GPT-4, ma i ricercatori si sono accorti che non tutti lo erano. Hanno, così, capito che le capacità di questi modelli non sono nettamente individuabili. È come se rappresentassero una “frontiera frastagliata” (la “jagged frontier” del titolo del paper). Idealmente, all’interno della frontiera ci sono i compiti che l’IA sa svolgere e fuori quelli che non sono alla sua portata. Il problema è che la frontiera è invisibile o frastagliata, cioè non è facile individuare a priori ciò che un sistema sa fare. Per esempio, la scrittura di un articolo o la generazione di idee sono un gioco da ragazzi per l’IA, mentre i calcoli matematici sono un problema.

Cosa succede quando si assegnano ai lavoratori problemi che l’IA non riesce a risolvere, ma che sono alla portata degli uomini? Nell’esperimento, i consulenti che hanno usato l’IA hanno avuto il 19% di probabilità in meno di produrre soluzioni corrette rispetto a quelli senza l’IA. In pratica, può accadere che la pigrizia o l’affidarsi incondizionatamente e senza contro all’IA, può portare ad errori che altrimenti non si farebbero (risultato emerso anche da un altro studio di Fabrizio Dall’Acqua “Falling asleep at the wheel“).

Strumenti di IA come livellatori di capacità

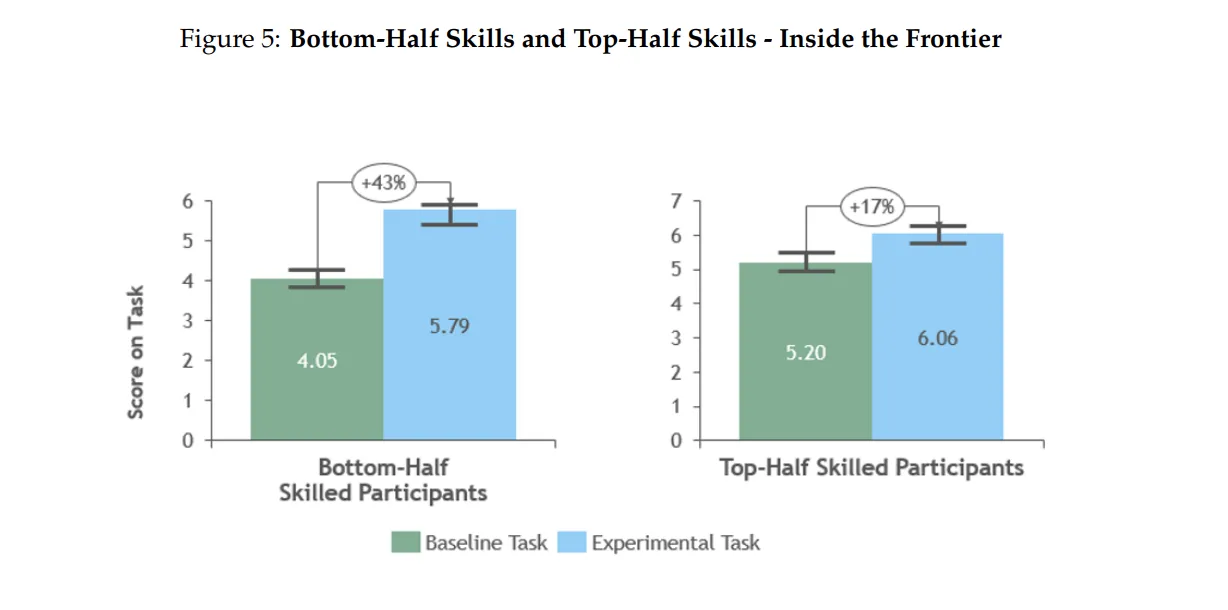

Un altro risultato interessante della ricerca è stato che gli strumenti di intelligenza artificiale agiscono come dei livellatori di abilità. Infatti è emerso che i consulenti che avevano ottenuto i peggiori punteggi, quando valutati all’inizio dell’esperimento (nella fase di assessment della baseline), hanno avuto il salto più grande nelle loro prestazioni quando hanno iniziato a usare l’IA (+43%).

Anche i consulenti migliori hanno ottenuto un miglioramento, ma in misura minore. Dunque, queste tecnologie di IA portano i lavoratori a livelli più alti di prestazione, con un effetto migliore sui meno capaci.

Centauri e Cyborg

La conclusioni del lavoro dei ricercatori mostrano l’esistenza di due due modelli diversi di utilizzo dell’IA da parte degli umani, lungo un continuum di collaborazione uomo-macchina. Ci sono consulenti che hanno lavorato scegliendo quali compiti delegare all’IA e quali svolgere autonomamente. Altri che hanno preferito integrare completamente l’IA nel proprio flusso di lavoro e interagendo continuamente con la tecnologia, come se fosse un compagno di lavoro. I primi sono stati soprannominati “Centauri”, perché come la creatura mitologica metà uomo e metà cavallo, mantengono una netta distinzione tra i ruoli. I secondo sono stati definiti “Cyborg” perché si sono comportati come se l’IA fosse parte di loro.

In generale, lo studio dimostra l’utilità dell’IA nell’aumentare l’efficacia e l’efficienza dei lavorativi di concetto. Sull’ultima distinzione tornerò in un prossimo articolo. E voi, siete centauri o cyborg?