Se il 2024 è stato l’anno della moltiplicazione delle applicazioni di intelligenza artificiale generativa e della diffusione ad un pubblico sempre più vasto, il 2025 sarà l’anno dell’adozione di massa e della maturità. Maturità vuol dire che vedremo IA con capacità più avanzate e un certo grado di autonomia. Noi avremo maggiore controllo e personalizzazione sui risultati.

Il 2025 sarà anche un anno di convergenza tra tecnologie diverse, che abbiamo finora fruito come separate: computing e IA, piattaforme web (social e ecommerce) e IA, realtà immersive e IA. I marketer saranno chiamati a metabolizzare le novità e a capire come sfruttarle per diventare “cyborg” attraverso un uso non occasionale, ma simbiotico di questi strumenti.

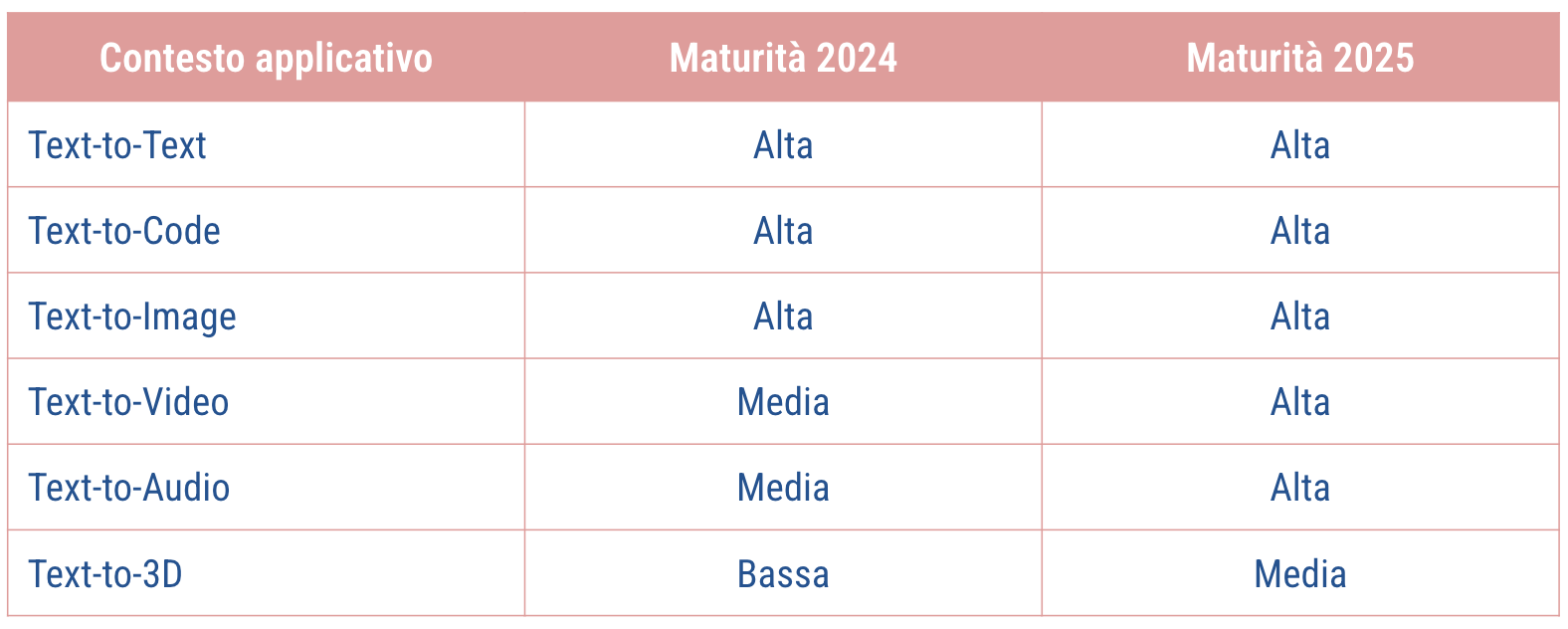

Livelli di maturità delle app di IA

Il 2025 sarà l’anno della maturità delle tecnologie di intelligenza artificiale generativa. Già a fine 2024 avevamo assistito ad un livellamento tra i modelli linguistici di grandi dimensioni (come ha dimostrato il caso Deepseek) e in parte anche tra i modelli di diffusione (si pensi ai traguardi di Flux e Recraft). Nei prossimi mesi potremo vedere un livellamento anche tra i prodotti di IA destinati agli utenti finali. Tutti cercheranno di aggiungere funzioni per espanderne le capacità. E un gran lavoro verrà fatto per rendere le interfacce più user friendly, alla ricerca di un’utenza di massa.

Gli strumenti per la generazione di testo e di codice andranno verso capacità agentive, mentre quelli per la creazione di immagini proveranno ad innovare aggiungendo maggiori possibilità di controllo e personalizzazione da parte dell’utente.

Il 2025 anche l’anno in cui gli strumenti text to video raggiungeranno livelli qualitativi professionali.

L’IA nel 2025: agentiva e più controllabile

Ma in che direzione andranno le applicazioni di intelligenza artificiale generativa nel 2025? Ne ho individuate tre che mi sembrano le più probabili, anche in questo ambito dovremmo aspettarci anche delle sorprese:

- Voce e Visione: nei contesti applicativi già giunti ad un alto grado di maturazione le innovazioni si sposteranno nell’ambito dell’interfaccia utente e dell’esperienza complessiva. I chatbot nati per interagire solo con la parola scritta, si trasformeranno in assistenti multimodali, cioè in grado di accogliere anche input sonori e visivi, oltre che rispondere anche con la voce. Alcuni segnali di questa tendenza stanno già emergendo, si pensi alla Funzione Vocale Avanzata di ChatGPT e a Gemini Live.

Questa estensione dei sensi che sicuramente interesserà i modelli linguistici, potrebbe essere accolta anche da altre tipologie di applicazioni come quelle per la creazione di immagini e musica; - Controllo e Personalizzazione: le applicazioni di GenAI che permettono di creare immagini, video, suoni e musica si stanno muovendo verso l’aggiunta di funzioni in grado di dare più controllo sul risultato finale, riducendo così la variabilità e l’influenza del caso. Ad esempio, Runway ha funzioni che permettono di muovere la macchina da presa virtuale in tutte le direzioni. Inoltre, ormai tutti i software per le immagini hanno aggiunto un editor per eliminare o aggiungere elementi agli output prodotti dal modello.

Altre funzioni punteranno a dare la possibilità di personalizzare gli output in modo da renderli meno standardizzati. Un passo in questa direzione l’ha fatto Midjourney, introducendo la possibilità di addestrare facilmente il software a riprodurre immagini basate sui propri gusti estetici; - Agenti autonomi: i modelli linguistici di grandi dimensioni dopo aver assunto le sembianze di chatbot conversazionali, si trasformeranno in agenti (con un certo grado di autonomia). Gli agenti non si limiteranno a rispondere alle nostre richieste, ma saranno in grado di portare a compimento le attività richieste, pianificando il da farsi e attingendo a risorse esterne. Alcuni esempi sono le funzioni Deep Research, introdotte da Google e poi da OpenAI, che permettono di realizzare dei report dettagliati dopo autonome ricerche fatte dal software. Le funzioni agentive si spingeranno anche verso l’utilizzo di risorse esterne come il browsing (si vedano le preview di Claude Computer Use e di Operator di ChatGPT).

In questo contesto evolutivo, il 2025 determinerà anche un’adozione della GenAI da parte di quella parte della popolazione meno interessata agli aspetti tecnici. Sarà una sorta di adozione “inconsapevole” o “disinteressata” perché molte persone si ritroveranno funzioni di IA all’interno dei dispositivi di uso quotidiano (smartphone, computer, occhiali, dispositivi casalinghi).

Se ti interessa approfondire ti consiglio di scaricare il report “Vincos Trends 2025” e di vedere il video in basso.